机器之心 & ArXiv Weekly Radiostation

参与:杜伟、楚航、罗若天

本周重要论文包括:ACL 2022 最佳论文、最佳主题论文和杰出论文,以及谷歌公布的包含 17 大类、1030 个家用物品的 13GB 家用物品 3D 扫描数据集。

目录:

Learned Incremental Representations for Parsing

Requirements and Motivations of Low-Resource Speech Synthesis for Language Revitalization

Evaluating Factuality in Text Simplification

Learning to Generalize to More: Continuous Semantic Augmentation for Neural Machine Translation

PP-YOLOE: An evolved version of YOLO

Google Scanned Objects: A High-Quality Dataset of 3D Scanned Household Items

Ditch the Gold Standard: Re-evaluating Conversational Question Answering

ArXiv Weekly Radiostation:NLP、CV、ML 更多精选论文(附音频)

论文 1:Learned Incremental Representations for Parsing

作者:Nikita Kitaev、Thomas Lu、Dan Klein

论文地址:https://aclanthology.org/2022.acl-long.220.pdf

摘要:该研究提出了一种增量句法表示,该表示包括为句子中的每个单词分配一个离散标签,其中标签是使用句子前缀的严格增量处理来预测的,并且句子标签序列完全确定了解析树。该研究旨在诱导一种句法表示,它只在句法选择由输入逐渐显示时才确定这些选择,这与标准表示形成鲜明对比,标准表示必须进行输出选择,例如推测性的附件,然后抛出相互冲突的分析。

该研究学习的表示在 Penn Treebank 上达到了 93.72 F1,且每个单词只有 5 bit;在每个单词为 8 bit 时,该研究在 Penn Treebank 上达到了 94.97 F1,这和使用相同的预训练嵌入时的 SOTA 解析模型相当。该研究还对系统学习到的表示进行了分析,他们研究了系统捕获的可解释句法特征等属性,以及句法歧义的延迟解决机制。

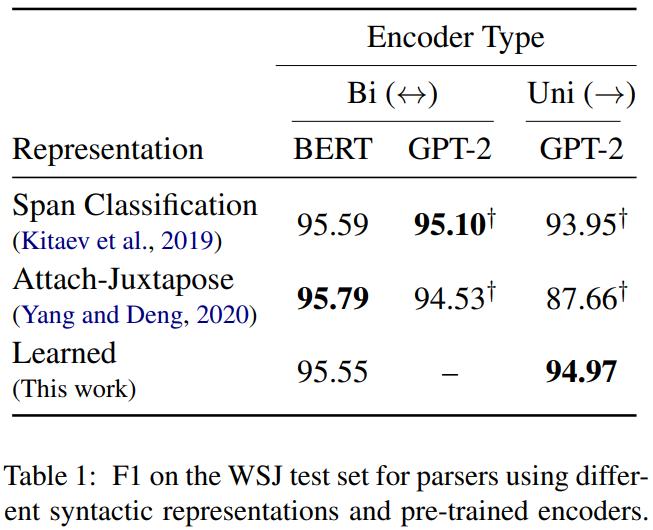

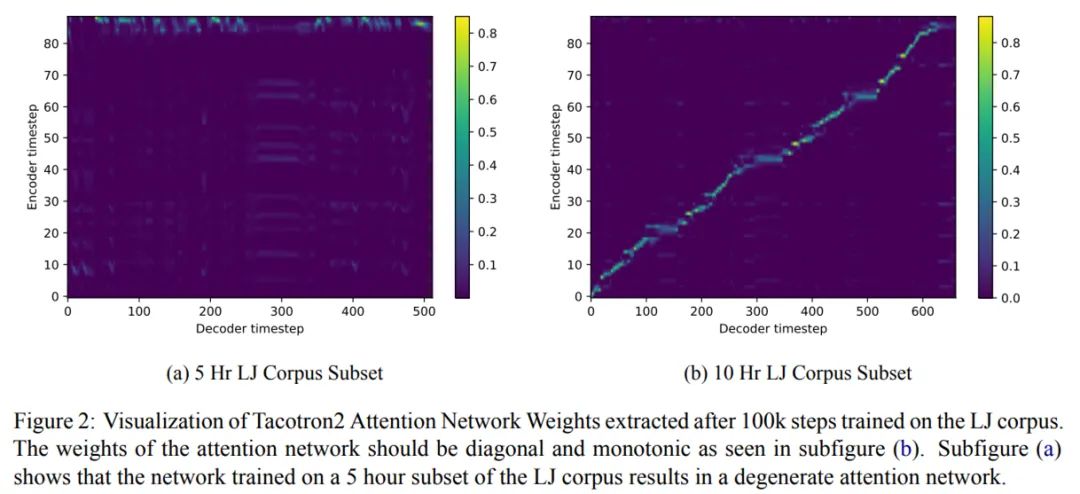

解析器使用不同句法表示和预训练编码器时,在 WSJ 测试集上的 F1 分数。

使用不同模型上下文时,在 WSJ 开发集上的解析性能。

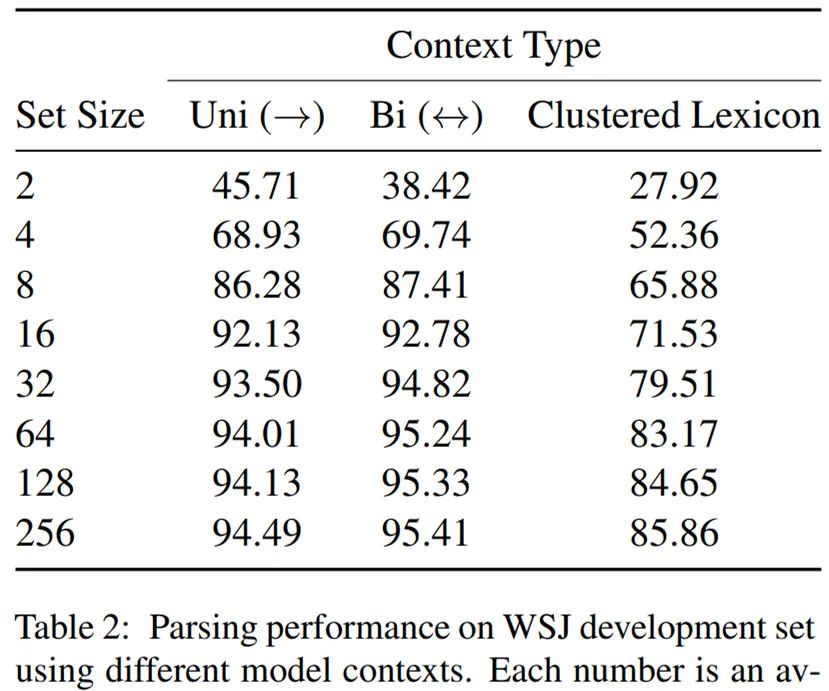

将本研究的 read-out 网络应用于句法标记序列的前缀表明句法决策致力于增量,并且不是所有的都推迟到句子最后。

推荐:加州大学伯克利分校的这项增量句法表示研究被评为 ACL 2022 最佳论文。

论文 2:Requirements and Motivations of Low-Resource Speech Synthesis for Language Revitalization

作者:Aidan Pine、Dan Wells、Nathan Brinklow 等

论文地址:https://aclanthology.org/2022.acl-long.507.pdf

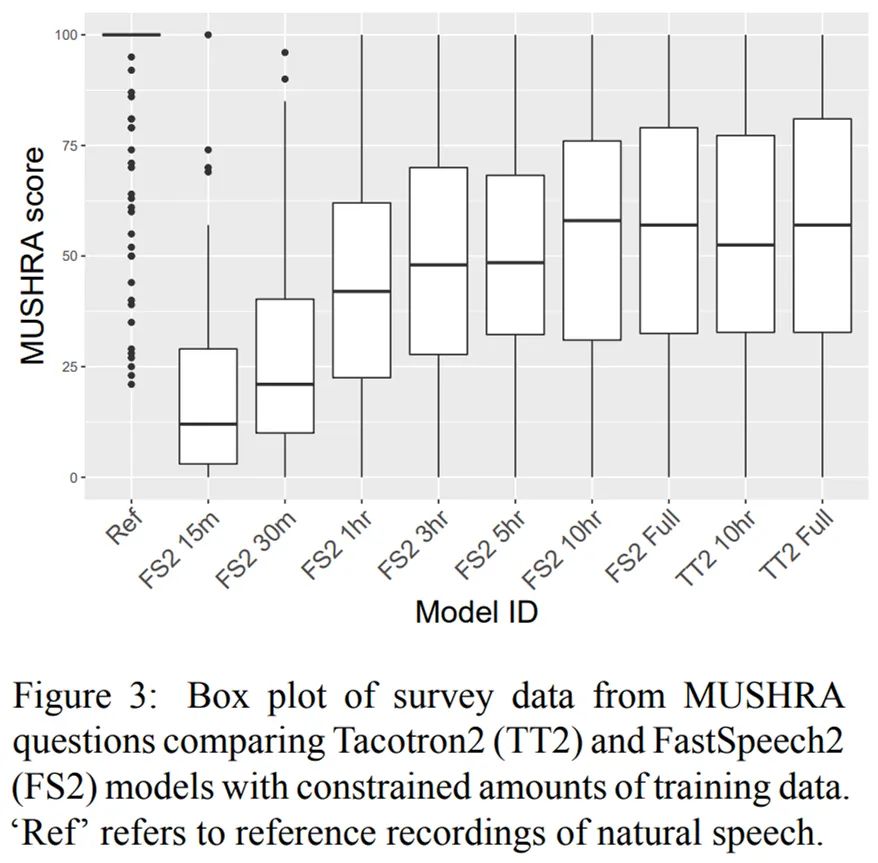

摘要:该研究阐述了语音合成系统的发展动机和目的,以振兴语言。通过为加拿大使用的三种土著语言 (Kanien 'kéha, Gitksan 和 SENĆOŦEN) 构建语音合成系统,该研究重新评估了需要多少数据才能构建具有 SOTA 性能的低资源语音合成系统。例如,该研究在英语数据的初步结果表明,在训练数据上训练 1 小时的 FastSpeech2 模型可以产生与训练 10 小时的 Tacotron2 模型语音自然度相当。

最后,该研究们鼓励在语音合成领域进行评估和课堂整合来进行未来研究,以实现语言复兴。

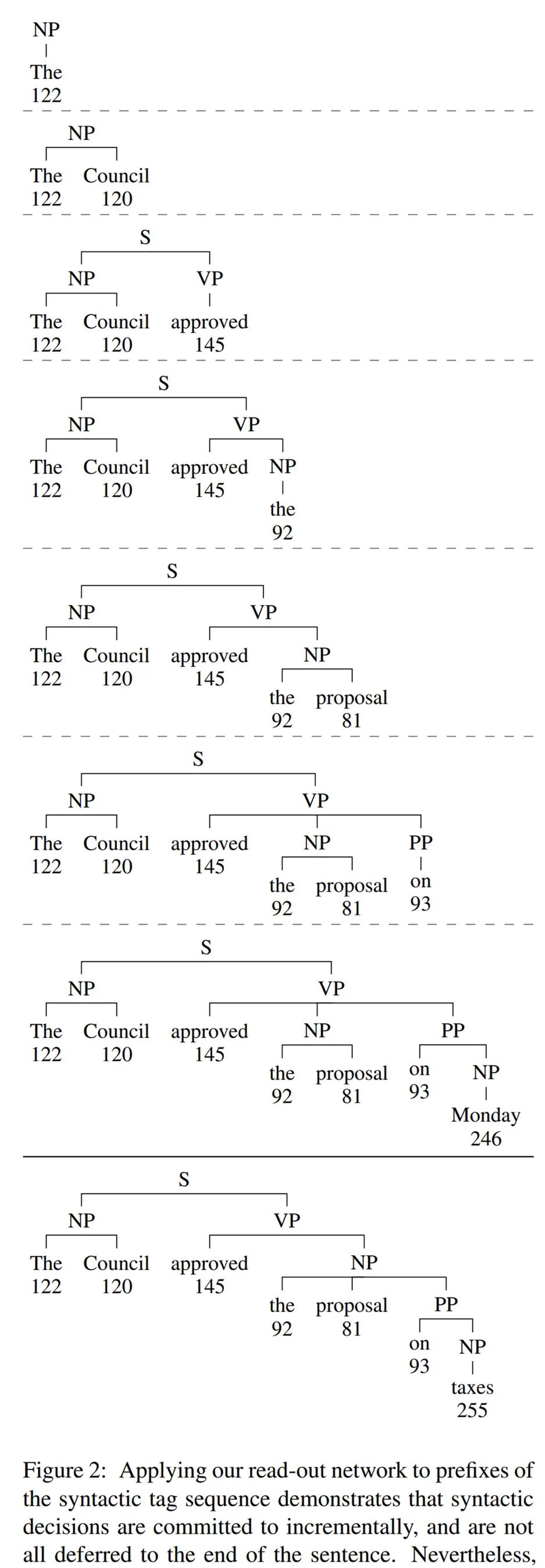

在 LJ 语料库上训练 100k 步后提取的 Tacotron2 注意力网络权重的可视化图。

来自 MUSHRA 问题中调研数据的箱型图,比较了 Tacotron2 (TT2) 和 FastSpeech2 (FS2) 模型与有限的训练数据量。

推荐:ACL 2022 最佳主题论文。

论文 3:Evaluating Factuality in Text Simplification

作者:Ashwin Devaraj、William Berkeley Sheffield、Byron C Wallace 等

论文地址:https://arxiv.org/pdf/2204.07562.pdf

摘要:自动简化模型旨在使输入文本更具可读性,但此类模型会在自动简化的文本中引入错误。因此,德克萨斯大学奥斯汀分校、东北大学的研究者提出了一种错误分类法,用来分析从标准简化数据集和 SOTA 模型输出中提出的参考资料。

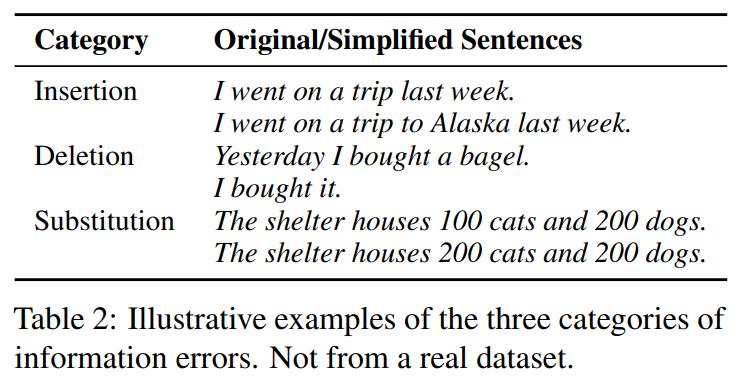

三种类型的信息错误的示例。

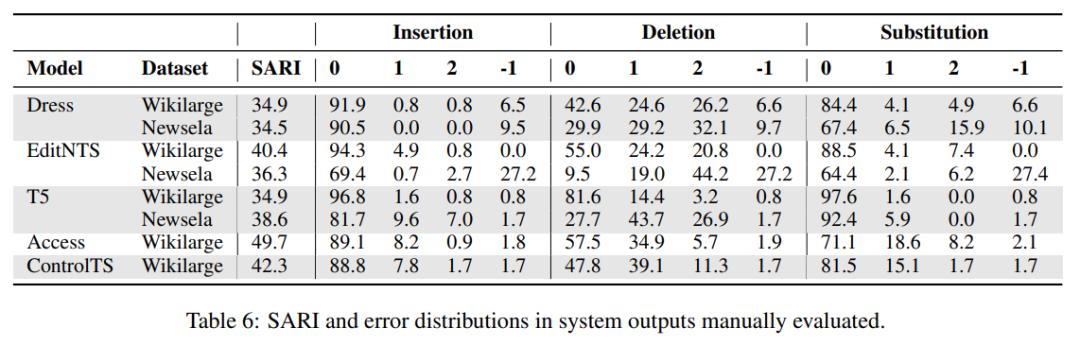

手动评估的系统输出中的 SARI 和错误分布。

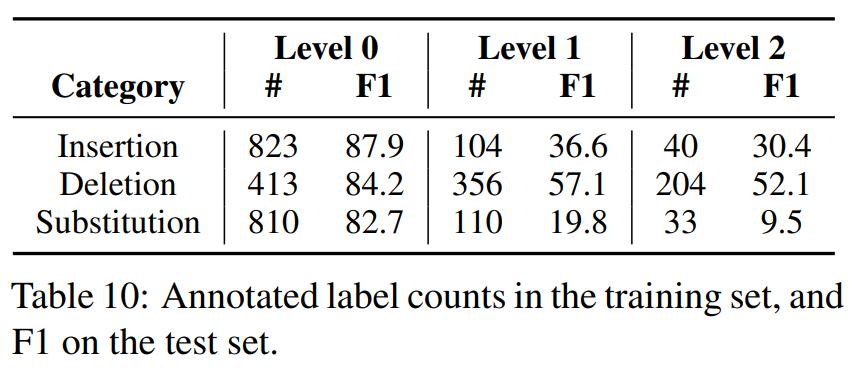

训练集中的注释标签计数和测试集上的 F1 分数。

推荐:ACL 2022 杰出论文之一。

论文 4:Learning to Generalize to More: Continuous Semantic Augmentation for Neural Machine Translation

作者:Xiangpeng Wei、Heng Yu、Yue Hu 等

论文地址:https://arxiv.org/pdf/2204.06812v1.pdf

摘要:监督神经机器翻译(NMT)的主要任务是学习生成以来自一组并行句子对的源输入为条件的目标句子,从而得到一个能够泛化到未见过实例的模型。然而,通常观察到模型的泛化性能很大程度上受训练中使用的并行数据量的影响。

阿里达摩院、中科院信息工程研究所、中国科学院大学的研究者提出了一种新的数据增强范式,称之为连续语义增强(CsaNMT),它为每个训练实例增加了一个邻接语义区域。

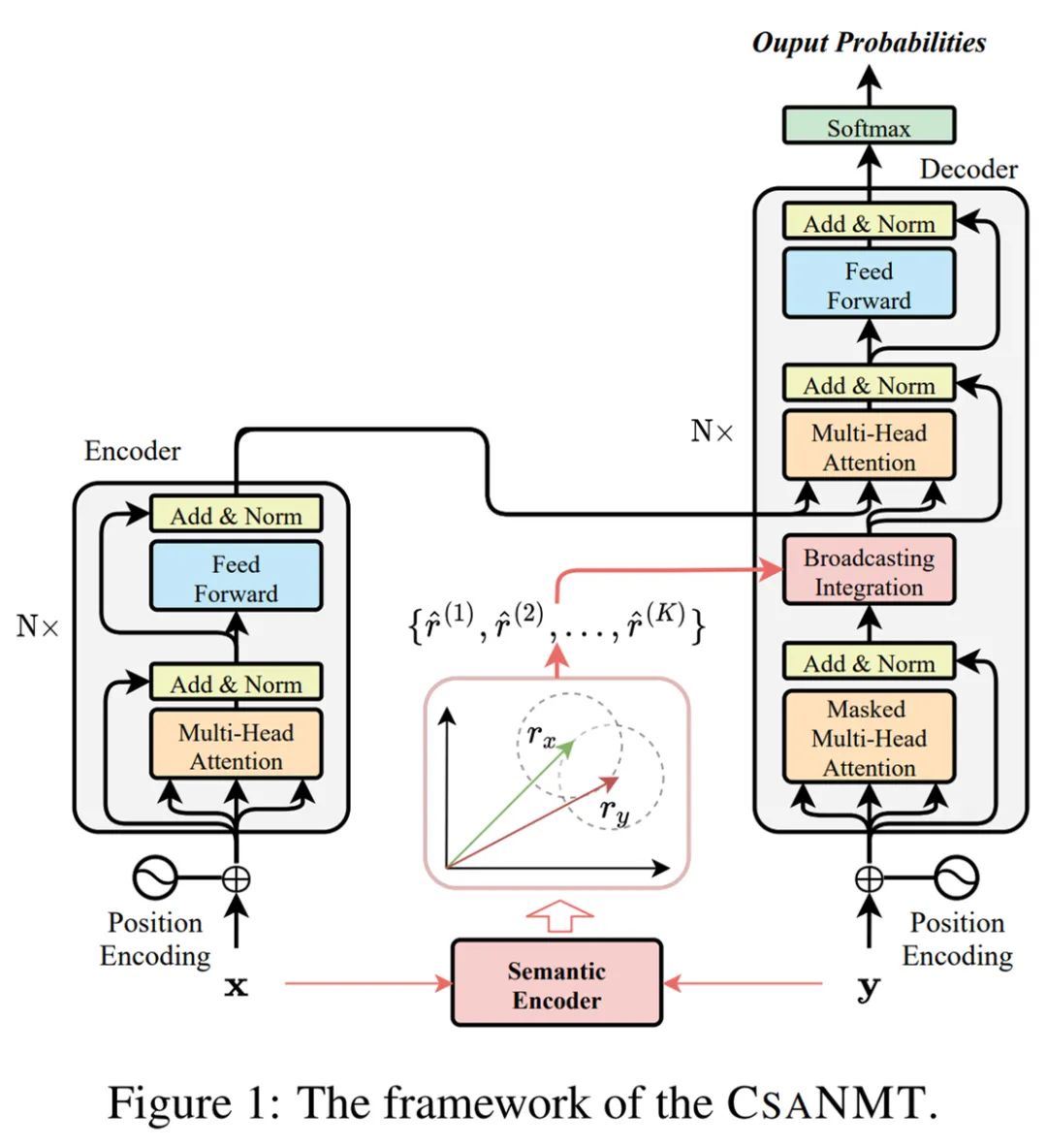

CSANMT 框架。

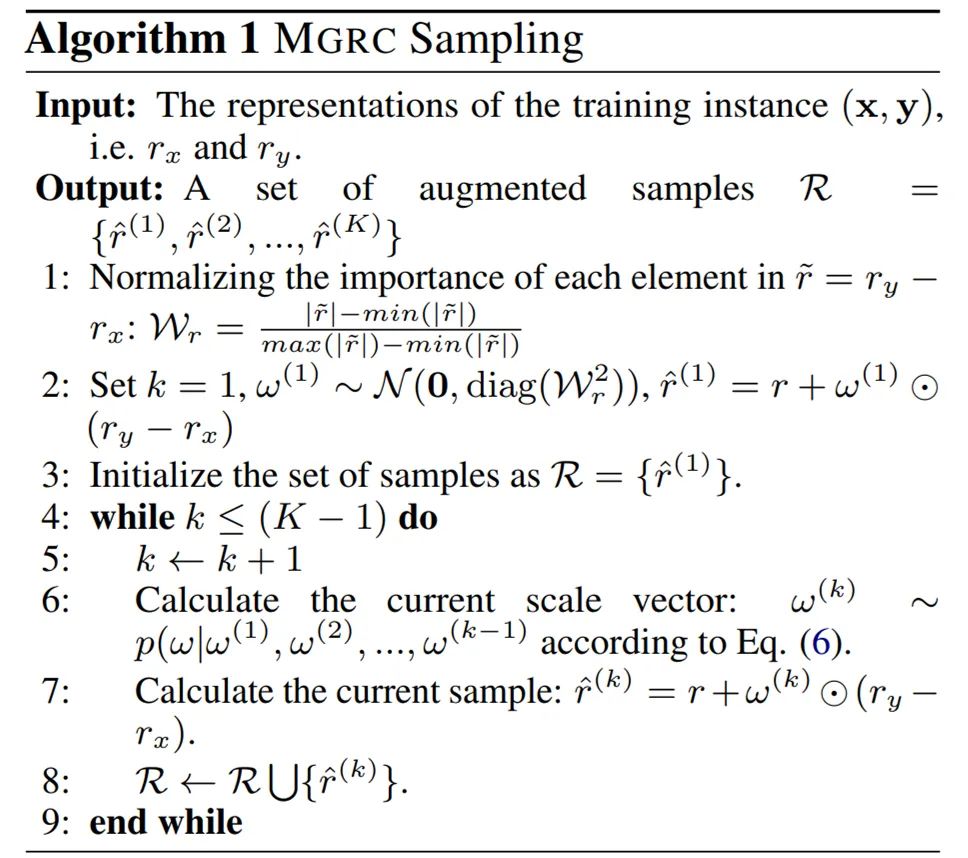

算法 1:MGRC 采样。

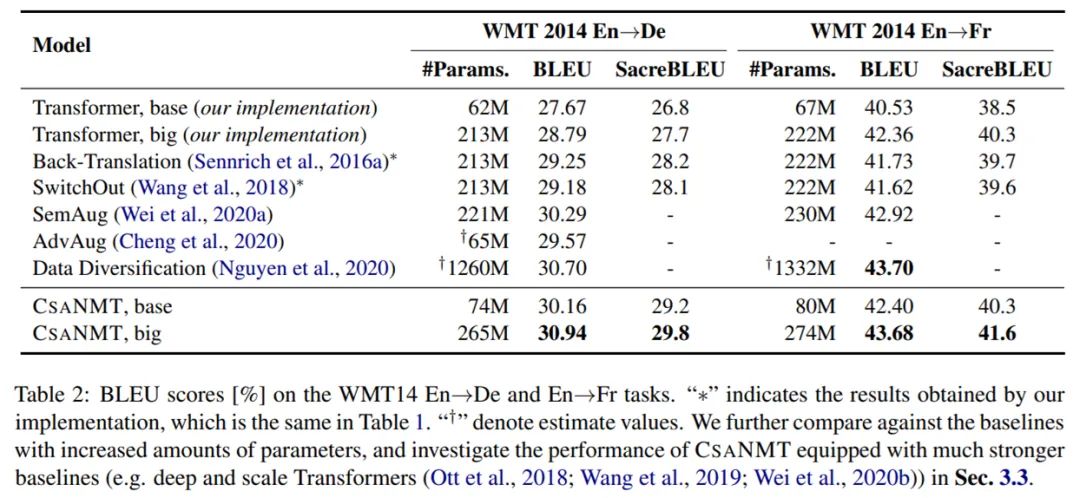

WMT14 En→De 和 En→Fr 任务上的 BLEU 分数。

推荐:ACL 2022 杰出论文之一。

论文 5:PP-YOLOE: An evolved version of YOLO

作者:Shangliang Xu、Xinxin Wang、Wenyu Lv 等

论文地址:https://arxiv.org/abs/2203.16250

摘要:百度飞桨团队发布了 PP-YOLOE,与其他 YOLO 系列算法相比,其具有更强的性能、更丰富灵活的配置方案以及更全硬件支持三大优势。

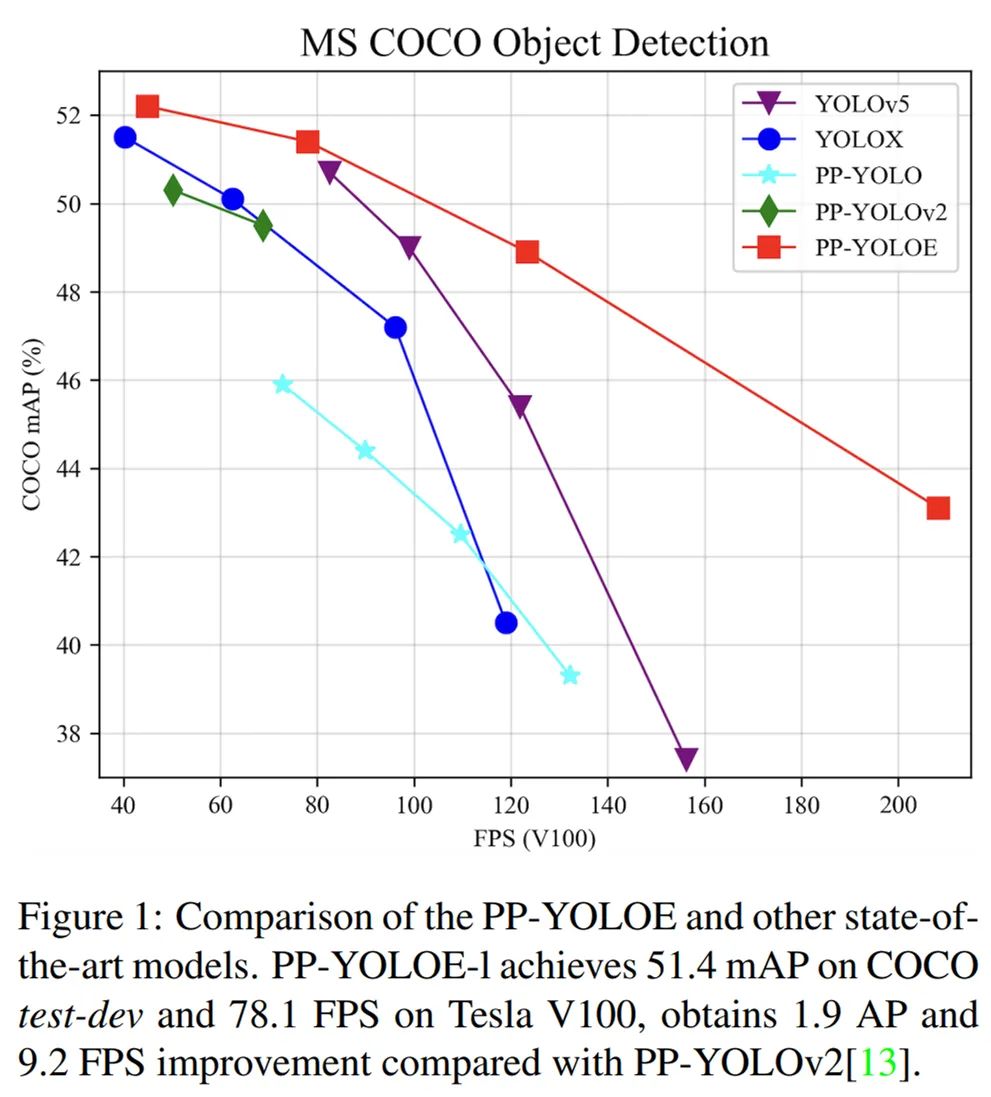

PP-YOLOE 各尺寸模型性能与其他模型对比示意图。

PP-YOLOE 模型结构示意图。

RepResBlock 和 CSPRepResStage 结构示意图。

推荐:YOLO 界再起波澜!mAP 51.4,149FPS,目标检测,一个就够了。

论文 6:Google Scanned Objects: A High-Quality Dataset of 3D Scanned Household Items

作者:Laura Downs、Anthony Francis、Nate Koenig 等

论文地址:https://arxiv.org/pdf/2204.11918.pdf

摘要:谷歌的研究者提出了 Google Scanned Objects (GSO) 数据集,这是一个由超过 1000 个 3D 扫描的家用物品组成的精选集,可用于 Ignition Gazebo、Bullet 模拟器和其他可以读取 SDF 模型格式的工具。

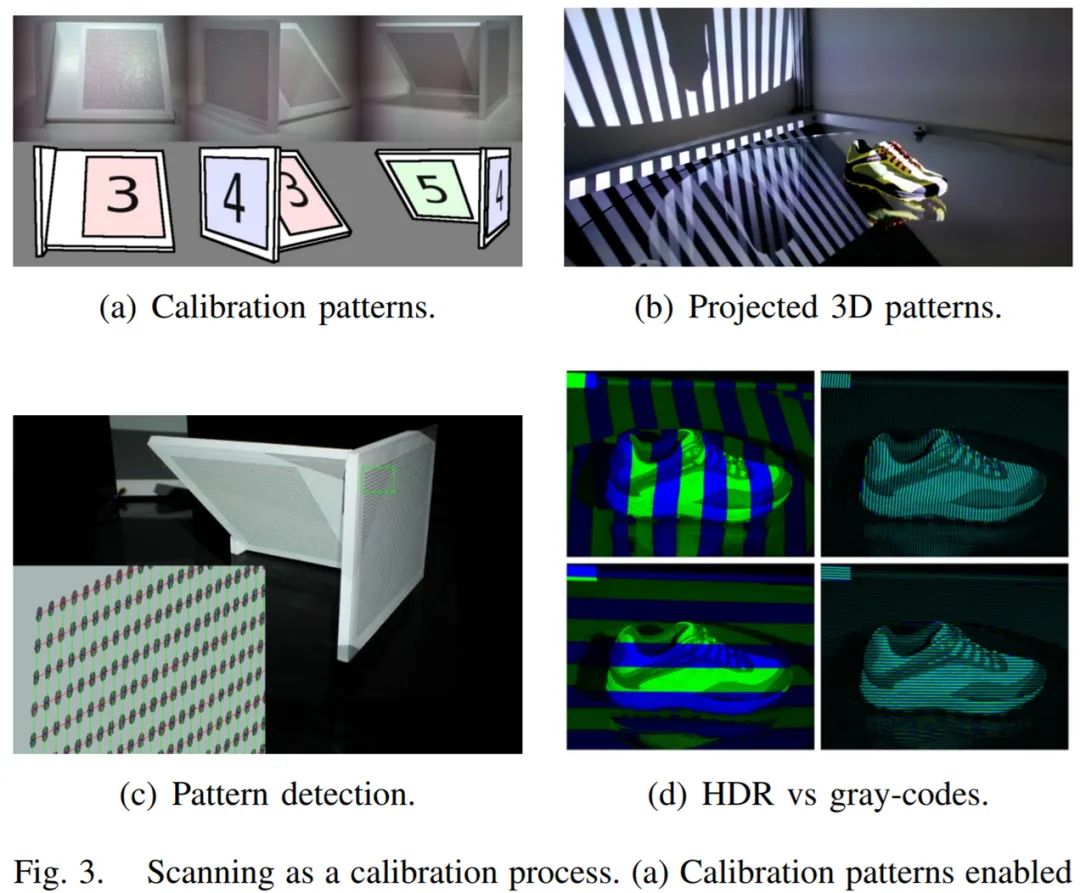

谷歌 GSO 的自定义 3D 扫描流程。

选取的 3D 模型数据集非常适合做仿真。

扫描校准过程。

推荐:谷歌公布 13GB 3D 扫描数据集:17 大类、1030 个家用物品。

论文 7:Ditch the Gold Standard: Re-evaluating Conversational Question Answering

作者:Huihan Li、高天宇、Manan Goenka、陈丹琦

论文地址:https://arxiv.org/pdf/2112.08812v2.pdf

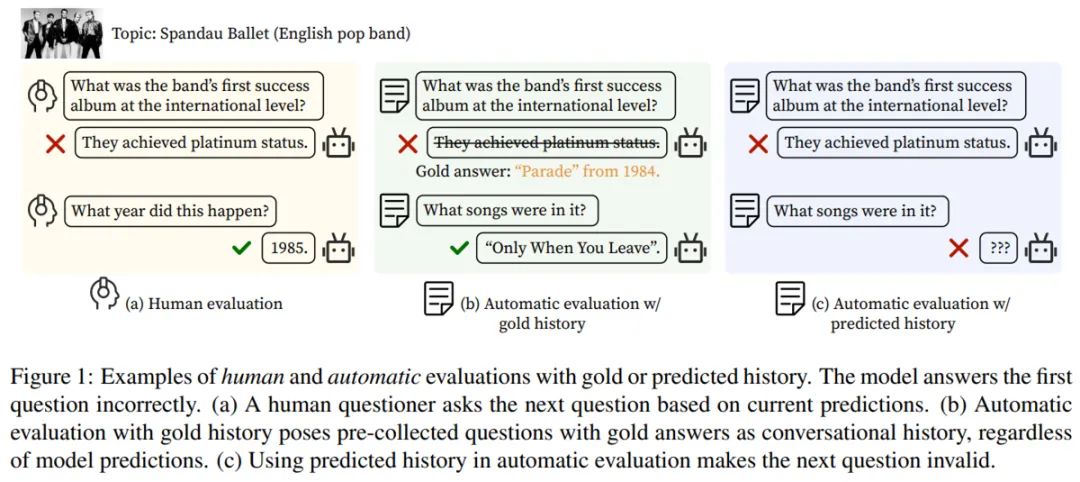

摘要:在这项工作中,研究者对 SOTA 对话式 QA 系统进行了首次大规模的人类评估,其中人类评估员与模型进行对话,并判断其答案的正确性。该研究发现人机(human-machine)对话的分布与人 - 人(human-human )对话的分布有很大的不同,在模型排名方面,人类评估和黄金历史(gold history)评估存在分歧。

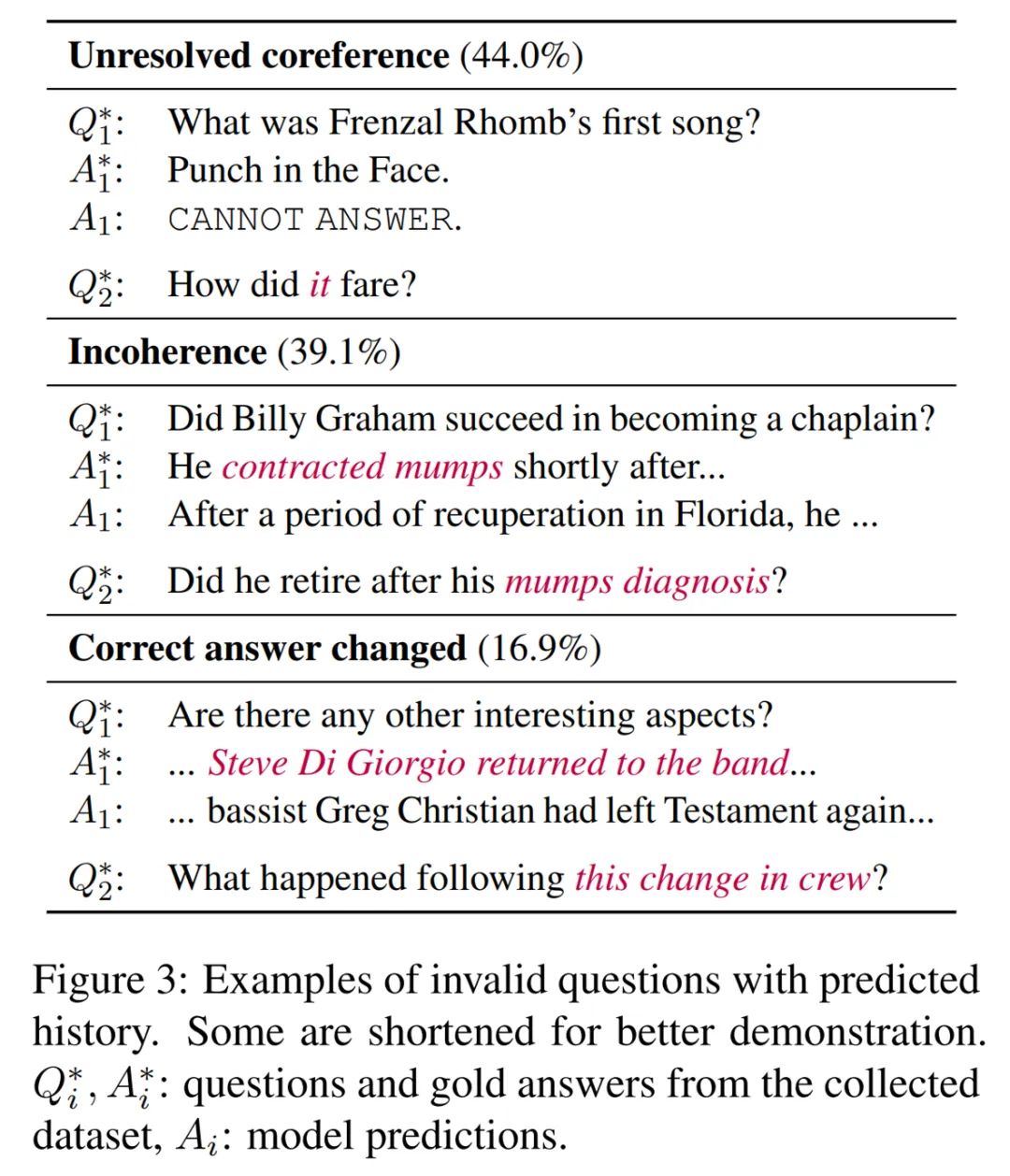

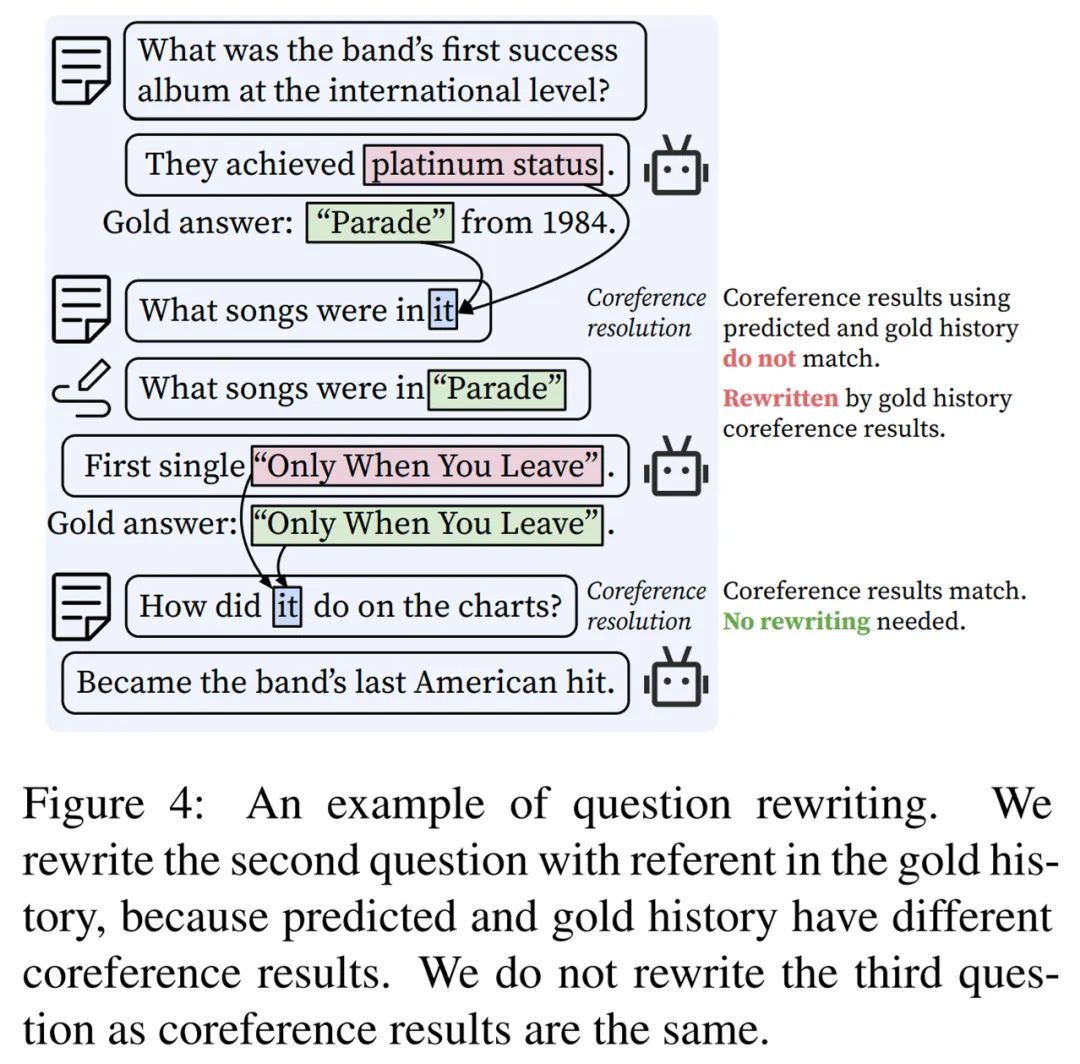

该研究进一步研究了如何改进自动评估,并提出了一种基于预测历史的问题重写机制,该机制可以与人类判断更好地关联。最后,该研究分析了各种建模策略的影响,并讨论了构建更好的对话式问答系统的未来方向。

使用 gold history 和 predicted history 的人类和自动评估示例。

使用 predicted history 的无效问题的示例。

问题重写示例。

推荐:ACL 2022 杰出论文之一。

ArXiv Weekly Radiostation

机器之心联合由楚航、罗若天发起的ArXiv Weekly Radiostation,在 7 Papers 的基础上,精选本周更多重要论文,包括NLP、CV、ML领域各10篇精选,并提供音频形式的论文摘要简介,详情如下:

本周 10 篇 NLP 精选论文是:

1. Voxel-informed Language Grounding. (from Trevor Darrell)

2. ACCoRD: A Multi-Document Approach to Generating Diverse Descriptions of Scientific Concepts. (from Daniel S. Weld)

3. Interlock-Free Multi-Aspect Rationalization for Text Classification. (from Boi Faltings)

4. Consistent Human Evaluation of Machine Translation across Language Pairs. (from Philipp Koehn)

5. Directed Acyclic Transformer for Non-Autoregressive Machine Translation. (from Yang Liu, Hang Li, Minlie Huang)

6. Entailment Tree Explanations via Iterative Retrieval-Generation Reasoner. (from Dan Roth)

7. LAGr: Label Aligned Graphs for Better Systematic Generalization in Semantic Parsing. (from Dzmitry Bahdanau)

8. Long-term Control for Dialogue Generation: Methods and Evaluation. (from Kilian Q. Weinberger, Ryan McDonald)

9. Twist Decoding: Diverse Generators Guide Each Other. (from Dragomir Radev, Noah A. Smith)

10. A Simple yet Effective Relation Information Guided Approach for Few-Shot Relation Extraction. (from Yang Liu)

本周 10 篇 CV 精选论文是:

1. On Demographic Bias in Fingerprint Recognition. (from Anil K. Jain)

2. A CLIP-Hitchhiker's Guide to Long Video Retrieval. (from Andrew Zisserman)

3. Real-time semantic segmentation on FPGAs for autonomous vehicles with hls4ml. (from Maurizio Pierini)

4. SuperWarp: Supervised Learning and Warping on U-Net for Invariant Subvoxel-Precise Registration. (from Bruce Fischl)

5. Masked Autoencoders As Spatiotemporal Learners. (from Kaiming He)

6. Unsupervised Segmentation in Real-World Images via Spelke Object Inference. (from Joshua B. Tenenbaum)

7. Beyond Greedy Search: Tracking by Multi-Agent Reinforcement Learning-based Beam Search. (from Xiao Wang, Dacheng Tao)

8. PYSKL: Towards Good Practices for Skeleton Action Recognition. (from Kai Chen)

9. TRT-ViT: TensorRT-oriented Vision Transformer. (from Jie Wu)

10. A Unified Framework for Implicit Sinkhorn Differentiation. (from Daniel Cremers)

本周 10 篇 ML 精选论文是:

1. Online Nonsubmodular Minimization with Delayed Costs: From Full Information to Bandit Feedback. (from Michael I. Jordan)

2. Trustworthy Graph Neural Networks: Aspects, Methods and Trends. (from Jian Pei)

3. An Empirical Investigation of Representation Learning for Imitation. (from Stuart Russell, Pieter Abbeel)

4. Bayesian Physics-Informed Neural Networks for real-world nonlinear dynamical systems. (from George Em Karniadakis)

5. Scalable algorithms for physics-informed neural and graph networks. (from George Em Karniadakis)

6. Continual Pre-Training Mitigates Forgetting in Language and Vision. (from Tinne Tuytelaars)

7. Revisiting PINNs: Generative Adversarial Physics-informed Neural Networks and Point-weighting Method. (from Dacheng Tao)

8. Neighborhood Mixup Experience Replay: Local Convex Interpolation for Improved Sample Efficiency in Continuous Control Tasks. (from Daniela Rus)

9. Causal Inference from Small High-dimensional Datasets. (from Martin Ester)

10. Nearly Optimal Algorithms for Linear Contextual Bandits with Adversarial Corruptions. (from Tong Zhang)